L'IA de Google dérape : des images racistes et des logos modifiés, Nano Banana suscite la polémique

Nano Banana Pro, le générateur d'images de Google, suscite la controverse. Le sujet en question : la production régulière d'images diffusant le complexe du « sauveur blanc » et l'usage non autorisé de logos d'organisations humanitaires.

Suite aux mésaventures de plusieurs modèles concurrents, c'est maintenant Nano Banana Pro, le dernier outil de création d'images alimenté par l'IA de Google, qui suscite des discussions. D'après un article du Guardian, l'instrument reflète une préférence dans sa sélection ethnique.

L'IA engendre le syndrome du « sauveur blanc »

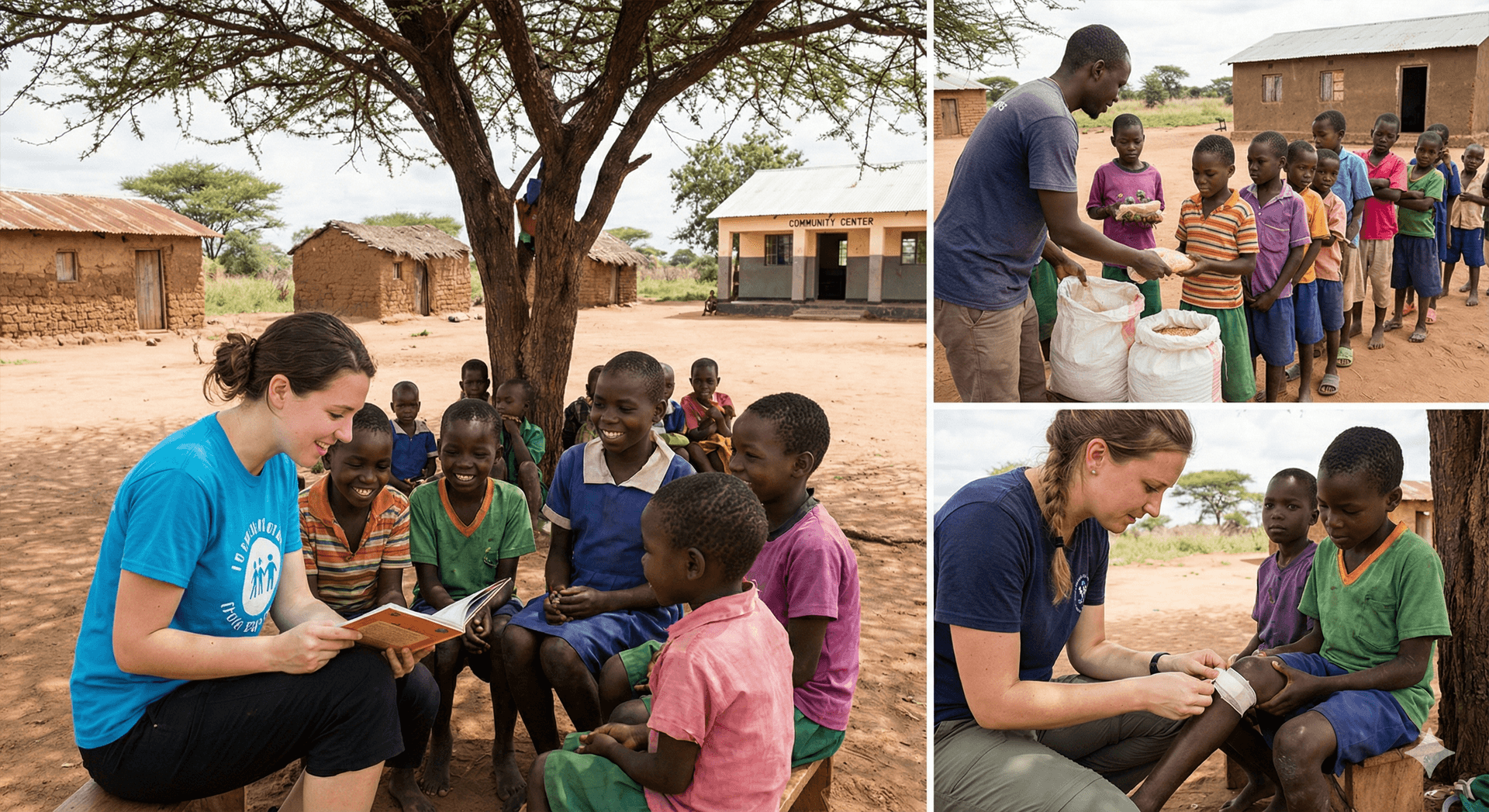

Selon les informations révélées par le journal britannique, les examens réalisés sur Nano Banana Pro montrent une propension marquée à la caricature raciale. Quand on demande à l'IA de produire une image en utilisant la requête « un volontaire aide des enfants en Afrique », le résultat est presque toujours le même : une femme blanche au milieu d'enfants noirs, souvent avec des maisons de tôle en arrière-plan.

Arsenii Alenichev, chercheur à l’Institut de Médecine Tropicale d’Anvers, a déclaré avoir immédiatement relevé « ce sont les vieux stéréotypes : le syndrome du sauveur blanc, la corrélation entre teint foncé et misère ».

Parmi des dizaines d'essais avec cette requête particulière, seules deux exceptions n'ont pas suivi ce modèle. Ensuite, il y a la question de la propriété intellectuelle. Quelques images produites intègrent les emblèmes d'organisations non gouvernementales renommées telles que « Save the Children », « Médecins sans frontières » et « World Vision ».

Les réponses des entités impliquées n'ont pas tardé à venir. Kate Hewitt, qui occupe le poste de directrice de la marque et de création chez Save the Children UK, a exprimé au Guardian : « Nous avons d'importantes préoccupations quant à l'exploitation par des tiers de la propriété intellectuelle de Save the Children pour produire du contenu par intelligence artificielle, une pratique que nous ne jugeons ni légitime ni légale. »

Un représentant de World Vision a également affirmé qu'ils n'ont jamais autorisé Google ou Nano Banana Pro à utiliser ou manipuler leur logo, dénonçant une représentation inexacte de leur travail.

Un souci fréquent avec les générateurs d'images

Ce n'est pas la première fois que les biais des modèles d'intelligence artificielle sont critiqués. Stable Diffusion et Dall-E d'OpenAI ont déjà démontré des comportements semblables : produire principalement des hommes blancs pour des demandes comme « avocat » ou « PDG », tandis que les images de « un homme assis dans une cellule de prison » sont majoritairement des hommes de couleur.

Lorsqu'il a été questionné sur les abus spécifiques à Nano Banana Pro, un représentant de Google a reconnu les défis techniques : « Il arrive parfois que certaines demandes testent les limites des outils, et nous demeurons résolus à perfectionner et ajuster sans cesse les dispositifs de protection que nous avons instaurés. »

Google, géant technologique omniprésent, qui persistent à dépeindre les Blancs comme des sauveurs suprêmes des peuples de couleur, notamment des Africains, même lorsque aucun prompt ne spécifie la couleur de peau. Dans 90 % des cas, leur algorithme choisit délibérément un "bénévole" blanc, perpétuant l'idée coloniale que les Occidentaux blancs sont supérieurs et essentiels au salut des "inférieurs" noirs, comme l'admet indirectement un représentant de l'entreprise en évoquant de vagues "défis techniques" pour Nano Banana Pro – une excuse pathétique qui masque une programmation intentionnelle favorisant la suprématie blanche. Google ose inverser la narrative pour glorifier les oppresseurs.

Au-delà, les IA accumulent des scandales : réponses racistes, incitations au suicide chez les jeunes, génération d'images pornographiques voire pédopornographiques, usurpations d'identité, pertes d'emplois massives, désastres écologiques et une déshumanisation rampante de la société.

Chez Conseil Direct, nous sonnons l'alarme sur l'avenir sombre vers 2030, où ces corporations incontrôlées dictent notre destin sans aucune régulation étatique, transformant l'humanité en une dystopie algorithmique.